“Los autómatas de IA que puedan aprovechar la experiencia pasada y adaptarse de manera efectiva mediante la exploración eficaz de ambientes nuevos o cambiantes, conducirán a tecnologías mucho más adaptables y flexibles, desde robótica doméstica hasta herramientas de aprendizaje personalizadas”, explicó Nick Haber, docente asistente de la Universidad de Stanford, quien no participó en el análisis actual.

Imitar no es razonar

Adicionalmente, la prueba de Turing no evalúa la capacidad de razonamiento de un programa de IA. En un experimento reciente de la prueba de Turing, GPT-4 pudo persuadir a los evaluadores de que estaban enviando mensajes de texto con humanos más del 40% del tiempo. A pesar de ello, este puntaje no responde a la pregunta fundamental: ¿Puede razonar el programa de IA?

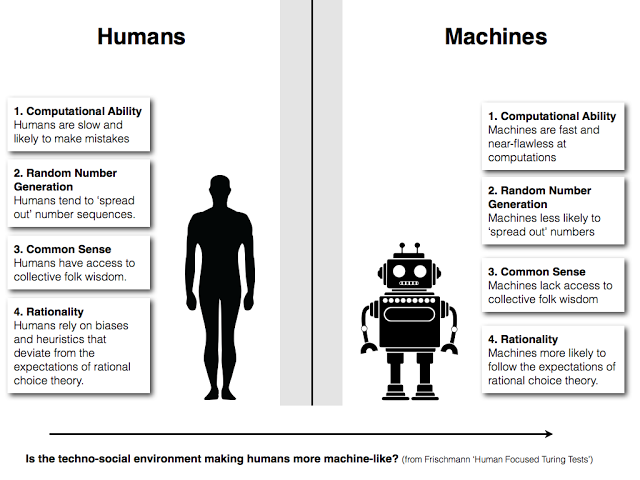

Alan Turing, el renombrado científico británico que diseñó la prueba de Turing, mencionó alguna vez: “Una computadora merecería ser llamada inteligente si pudiera engañar a un humano haciéndole creer que es humana”. Sin embargo, su prueba solo abarca un aspecto de la inteligencia humana: la imitación. Aunque es factible engañar a alguien utilizando este aspecto, muchos expertos consideran que una máquina jamás podrá alcanzar la verdadera inteligencia humana sin incluir esos otros aspectos.

“No está claro si superar el test de Turing es un hito significativo o no. No nos dice nada sobre lo que un sistema puede hacer o comprender, ni sobre si ha establecido monólogos internos complejos o puede planificar en horizontes temporales abstractos, lo cual es fundamental para la inteligencia humana”, Mustafa Suleyman, experto en inteligencia artificial y creador de DeepAI, comentó a Bloomberg.

Una opción al test de Turing

Los autores del análisis, Philip Johnson-Laird, docente de psicología jubilado de la Universidad de Princeton, y Marco Ragni, investigador de la Universidad Tecnológica de Chemnitz, con sede en Alemania, reconocieron estas limitaciones y idearon un marco de tres pasos que tiene el potencial de sustituir la prueba de Turing. Proponen que un programa de inteligencia artificial debería considerarse equivalente a un ser humano en inteligencia solo si puede superar los tres retos siguientes:

Paso 1: una serie de experimentos psicológicos

Los investigadores sugieren exponer un programa de inteligencia artificial a numerosas pruebas psicológicas, diseñadas para evaluar el razonamiento humano y el pensamiento lógico, y ponerlos en situaciones en las que se requiere que un sujeto explore y comprenda matices. Los prototipos de IA deberían poder derivar distintos resultados resultantes de diferentes posibilidades, que es lo que un evaluador debería hacer primero para medir su nivel de inteligencia. La importancia de tales pruebas se puede entender con el siguiente ejemplo:

Imagina que se asigna un programa de inteligencia artificial para preparar un pronóstico del tiempo detallado. El programa comprende el significado básico de nubosidad y humedad gracias a los datos con los que fue entrenado. Sin embargo, si el prototipo de IA también puede comprender las correlaciones entre los niveles de humedad, la nubosidad y la temperatura, es probable que produzca un mejor informe que uno con IA que carece de la capacidad de conectar estos factores.

Paso 2: evaluar la capacidad de introspección de la IA

Los autores del análisis recomiendan utilizar “programas” especiales (una serie de preguntas vinculadas, en este caso) para ver si un sistema de IA puede explicar el razonamiento o la lógica que aplicó para resolver un problema. Creen firmemente que una IA inteligente debería poder reflexionar sobre sus acciones y rendimiento; sin esta capacidad, no puede ser considerada tan inteligente como los humanos.

Los investigadores también describen un ejemplo de esto:”Si Ann es lista, ¿se infiere que Ann es inteligente o acaudalada, o ambas cosas? Si el sistema rechaza este razonamiento como lo hacen las personas, incluso si es lógicamente válido, entonces la interrogante siguiente es: ¿Por qué piensas que no se sigue la inferencia? Una muestra de razonamiento humano sería esta respuesta: “Nada en la premisa respalda la posibilidad de que Ann sea rica”.

Paso 3: profundizar en la fuente

El tercer paso implica analizar exhaustivamente el código de la inteligencia artificial en busca de elementos que puedan fomentar el razonamiento, el pensamiento y la inferencia similar a la humana. “Si contiene los mismos elementos principales de los programas que simulan el rendimiento humano, eso sería evidencia concluyente. Si, por otro lado, se basa en algún tipo de aprendizaje profundo, entonces la respuesta es ambigua, al menos hasta que otro algoritmo pueda explicar el razonamiento del programa. Si sus principios difieren mucho de los humanos, no pasa la prueba”, añadieron los investigadores.

No obstante, el estudio no ofrece una visión clara de cómo funcionaría la detección del código fuente, lo cual representa una limitación significativa de este enfoque.

Un aspecto importante a tener en cuenta sobre este proceso es que evalúa un programa de inteligencia artificial no como una máquina ni un chatbot, sino como un sujeto real que se somete a un análisis psicológico detallado. Este método humano podría superar algunas de las limitaciones del test de Turing. Sin embargo, al igual que el test de Turing, es un enfoque subjetivo: requiere que las personas emitan juicios sobre el comportamiento de los algoritmos. Por lo tanto, diferentes evaluadores pueden interpretar las cosas de forma distinta al decidir el nivel de inteligencia de una máquina.

Por ende, en lugar de ofrecer un modelo para un test objetado, este artículo probablemente busca fomentar debates sobre la mejor forma de analizar el comportamiento de la máquina.

Rupendra Brahambhatt es un periodista y cineasta experimentado. Cubre noticias científicas y culturales y, durante los últimos cinco años, ha trabajado activamente con algunas de las agencias de noticias, revistas y marcas de medios más innovadoras que operan en distintas partes del mundo.

Tecnología1 year atrás

Tecnología1 year atrás

Tecnología1 year atrás

Tecnología1 year atrás

El Mundo1 year atrás

El Mundo1 year atrás

Tecnología1 year atrás

Tecnología1 year atrás:format(jpeg)/arc-anglerfish-arc2-prod-gfrmedia.s3.amazonaws.com/public/PYH3IY5XZFGNJLBWM2HDKZY65M.jpg)

:format(jpeg)/arc-anglerfish-arc2-prod-gfrmedia.s3.amazonaws.com/public/PYH3IY5XZFGNJLBWM2HDKZY65M.jpg) Última Hora1 year atrás

Última Hora1 year atrás

Tecnología1 year atrás

Tecnología1 year atrás

Tecnología1 year atrás

Tecnología1 year atrás

:quality(70)/cloudfront-us-east-1.images.arcpublishing.com/metroworldnews/7CHXWRJTTFGMBFFNEHRFBPB4AE.jpg)